L’IA est-elle, comme Dieu selon certains athées, un vecteur d’aliénation, où l’humain se dépossède de ses propres qualités pour les projeter vers cet outil technologique? Cette grille de lecture feuerbachienne est celle que fournit le philosophe Mathieu Corteel dans son nouveau livre Ni Dieu ni IA (La Découverte). Pour QG, le chercheur à Sciences Po et Harvard souligne combien le développement capitaliste de l’IA exproprie, exploite et aliène l’intelligence collective, tout en appelant à ne pas rejeter en bloc l’utilisation de l’IA, qui s’avère quand même utile, selon lui, si on en fixe collectivement des limites. Interview par Jonathan Baudoin

QG: Peut-on dire que l’expansion de l’intelligence artificielle générative dans la création scientifique ou culturelle, tend à amoindrir l’intelligence humaine, à l’exproprier de ses prérogatives?

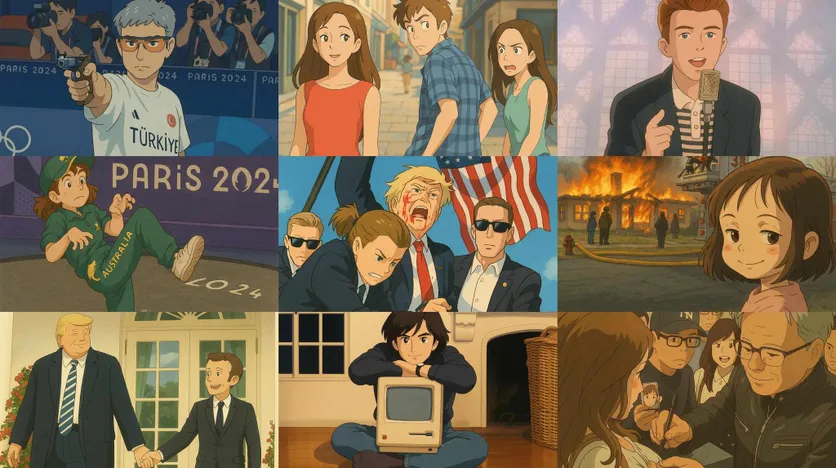

Ce que j’ai tendance à dire, c’est qu’on est face à une situation où l’expropriation, l’exploitation de l’intelligence collective, est devenue tellement ample qu’on assiste à une dévaluation de l’intelligence humaine. À partir de l’accumulation primitive des géants de la tech, qui se sont accaparés toutes nos données en prenant des positions dominantes sur le marché, on a vu de nouvelles puissances hégémoniques émerger, notamment avec le développement de ces IA génératives. C’est une crise de la culture dans laquelle on est embarqué actuellement. Tout ce qui avait trait à une protection du droit d’auteur, de la propriété intellectuelle, est mis à mal. L’exemple récent des studios japonais Ghibli qui se sont faits exproprier leur mode de construction d’images par les américains OpenAI, avec une production massive de contenus, illustre bien le problème.

Mais, c’est un processus qui est à l’œuvre depuis un moment. Des auteurs comme Yann Moulier Boutang, André Gorz ou Antonio Negri, avaient déjà souligné cette transformation du capitalisme cognitif. Yann Moulier Boutang distinguait à ce propos l’accumulation de deux types d’immatériels. Les immatériels 1, protégés par les droits d’auteur (brevets, etc.) et les immatériels 2 qui y échappent (nos données issues de notre activité en ligne). La captation des immatériels 2 a permis l’établissement des banques de données des géants de la Tech. Maintenant, cette accumulation primitive des données laisse place à une exploitation massive de l’IA dans toute activité cognitive et culturelle humaine.

Pourquoi développez-vous une approche de « scepticisme anthropotechnique » dans cet essai?

Ma position vient d’un double rejet. D’une part, éviter l’optimisme des technophiles qui promettent monts et merveilles pour l’avenir avec des IA appelées à nous sauver de tout type de catastrophe, ou à nous libérer d’avoir à prendre des décisions parce qu’apparemment, on est pétri de biais cognitifs. D’autre part, ne pas céder non plus à une forme de catastrophisme qui relève également d’un messianisme, comme quoi l’IA serait le dernier élément apocalyptique amenant à un grand remplacement – terme que je déteste – de l’humain.

Pourquoi sceptique? C’est pour sortir des dogmes qu’on a développés sur l’IA. On a beaucoup parlé de la conscience de la machine, de la fameuse « singularité » technologique, qui sont de l’ordre de la spéculation. On a délaissé la question fondamentale de l’impact économique et culturel de l’IA. On le voit, aujourd’hui. Ce système d’expropriation et d’exploitation de l’intelligence collective amène des choses peu réjouissantes.

Ma position est la suivante: ne pas tomber dans un biais ou l’autre, mais mobiliser une réflexion sceptique pour amener le lecteur à se poser des questions de manière active, une visée critique sur l’IA, en comprenant bien la part de projections anthropologiques qui nous illusionnent sur ces objets-là; auxquels on délègue une part de décision et d’action au risque de s’engager dans le non-sens. J’utilise le scepticisme dans cet angle-là, pour montrer les paradoxes pragmatiques dans lesquels on s’engage avec les IA, dès lors qu’on leur prête des qualités qu’elles n’ont guère.

C’est là tout l’intérêt du propos. C’est de montrer qu’avant de démultiplier les IA dans tous les types d’activités cognitives humaines, il serait bon de réfléchir sur les limites et d’avoir une visée plus rationnelle, raisonnable, pour ne pas saboter la part d’intelligence humaine nécessaire à toute décision ou action. Ce qui m’inquiète, tout particulièrement, c’est l’impact de l’intelligence artificielle sur le jugement humain, sur notre capacité à prendre des décisions et à faire des choix sociaux.

En dépit de ses apports à la santé, comme vous le relevez dans votre livre, estimez-vous que l’IA va générer une médecine à deux vitesses, avec des soins inaccessibles pour les plus pauvres? Une médecine sans médecins n’est-elle pas plus risquée pour la santé humaine?

C’est là où le scepticisme est intéressant à mettre en œuvre. Il ne faut pas développer l’IA dans toutes les dimensions de la médecine, du diagnostic clinique au pronostic, en passant par la gestion totale des services de soins des patients, le suivi, etc. Il faut être pragmatique, dans le sens où on doit se demander au préalable à quoi elle peut nous aider concrètement. L’idée de la substitution du médecin, d’une médecine sans médecins et ni malades, c’est de l’ordre du fantasme, de l’idéologie, ça ne correspond à aucune réalité de la médecine actuelle et ça amène à une dévaluation du service public médical.

Pour les politiques publiques, les IA sont appelées à répondre à tous les problèmes structurels d’organisation des services de soins. Seulement, il ne faut pas croire que l’IA serait la réponse. Il y a des services d’urgence à genoux, des déserts médicaux qui s’étendent dans notre pays. Mais l’IA n’est pas une solution miracle. Elle peut même d’ailleurs générer une médecine à deux vitesses dans l’accès aux soins. En consolidant l’accès à des médecins humains aux seuls citadins et en rabattant la télémédecine et l’IA dans les déserts médicaux.

L’IA a cependant un rôle important à jouer dans l’ordre de la connaissance médicale, dans certains domaines d’application très concrets. Par exemple, dans l’imagerie médicale pour détecter plus finement et précocement des maladies. Néanmoins, cela ne se substitue pas au regard médical, ni au jugement du médecin. L’Académie de médecine a bien statué sur le fait que le jugement humain est la seule garantie du diagnostic et du traitement.

Est-ce que l’IA renforce la tentation de basculer vers des régimes totalitaires 2.0 avec des lois comme la loi JO 2024 instaurant la vidéosurveillance algorithmique?

Je serais plus nuancé: il y a une tentation autoritaire clairement marquée qui tient à la dérégulation de l’IA aux États-Unis qui génère une grande inquiétude. Car, le développement dérégulé de ces technologies est extrêmement dangereux pour des populations déjà victimes de discriminations. Notamment dans la surveillance, car ces outils sont pétris de biais discriminants qui peuvent amener à une police algorithmique criminelle, comme c’est le cas aux États-Unis, et à des interpellations violentes, voire des assassinats assistés par IA. À la suite de la mort de George Floyd à Minneapolis, un collectif de mathématiciens s’est mobilisé en soutien au mouvement Black lives matter pour dénoncer ces technologies pétries de biais racistes. Actuellement, en France on fait des expérimentations avec ces technologies, comme avec la loi JO, permettant la VSA ; qui n’est toutefois pas encore implémentée dans notre pays. Mais c’est en discussion. Néanmoins, au niveau européen, avec l’AI Act, tout ce qui est de l’ordre de la biométrie est considéré à haut risque. Ces IA ne sont donc pas normalement homologuées, en théorie. En pratique, c’est plus compliqué. On s’autorise des usages dans des situations d’État d’urgence chronique qui permettent d’instaurer ce genre d’outils. Il y a eu la loi JO. On attend encore les évaluations de politique publique là-dessus. Quoi qu’il en soit, il y a une tentation ; J’espère qu’on ne va pas y céder.

En quoi l’IA contribue à renforcer les inégalités selon vous?

L’IA est le miroir de nos données! Elle reproduit des biais racistes, discriminants, dans ses résultats. C’est là que la dérégulation actuelle, aux États-Unis, pose problème car vous aviez un institut, le AI safety institute, qui avait été mis en place pour réguler ces biais. Vous savez que la plupart des IA viennent des États-Unis. La dérégulation faite par Trump à ce niveau-là fait qu’il n’y a plus de régulation sur les biais de genre, les biais raciaux, etc. Le problème est qu’il y a, derrière, une espèce de discours scientiste qui crée une sorte d’illusion à cet égard, en disant: « C’est des mathématiques, des algorithmes solides ». Néanmoins, le fait est que ça fait un bon nombre d’années que beaucoup de chercheurs ont pointé du doigt ces types de biais à l’égard de populations victimes de la société de contrôle. Il y a un gros risque actuel de voir quelque chose de similaire à ce qui s’était passé au 19ème siècle avec le racisme scientifique, la mesure anthropométrique du corps et des distinctions pour reconnaître les traits caractéristiques du criminel ou du déviant, qui relèvent de la pseudo-science et qui, malheureusement, se dotent d’une armature mathématique qui donne l’illusion d’une neutralité alors qu’il n’y en a aucune.

Y a-t-il un moyen d’opérer un contrôle collectif de l’IA? Si oui, est-ce que cela permettrait une bascule du capitalisme cognitif avancé vers du cyber-anarchisme, tant le titre de votre essai fait écho à la devise anarchiste « Ni Dieu ni maître »?

Le titre est venu davantage du côté sceptique. Mais pourquoi pas faire un lien avec Blanqui. Mais l’idée est de déconstruire la divination de l’IA, de sortir des transcendances de l’IA. Il y a un geste qui va dans un sens de sortie de l’aliénation. Il faut trouver des agencements qui soient émancipateurs collectivement. Sortir des effets de transcendance, rester dans un plan d’immanence collectif sur le sens qu’on donne à ces outils. C’est-à-dire avoir la capacité de s’en doter selon des besoins concrets, collectifs. Ne pas avoir une imposition de faux besoins, qui se démultiplient dans l’ensemble des activités qui sont dans les mains des géants américains de la tech dont l’intérêt est absolument contraire à l’émancipation des collectifs et des individus.

Comment on s’émancipe de tout ça? D’abord par un changement des habitudes. Est-il possible de se passer des technologies? Il est bon d’en définir des limites d’application. Quelles sont les véritables nécessités d’utilisation de l’outil? Quelles en sont les dimensions futiles? Voilà des questionnements qui donnent une marge de manœuvre.

Il faut se souvenir que le numérique est venu de l’idée du logiciel libre, des creative commons, qui permettaient le partage des logiciels. Toute l’éthique des hackers, qui avait une visée libertaire, a malheureusement été corrompue par le capitalisme cognitif dans son ensemble. Est-ce qu’on peut espérer retourner à ça? Je crois qu’aujourd’hui, il est à craindre qu’on va vers une trajectoire inverse. L’important, je crois, c’est de bâtir une culture critique collective à cet égard, une capacité de fuir certains dispositifs comme X/Twitter. On a vu une migration qui s’est faite. Il y a des gens qui ont conscience que l’outil est dangereux et aliénant, entre les mains de personnes peu respectables qui ont des projets politiques et sociétaux nauséabonds.

Je crois que la solution à la crise culturelle doit passer par l’édification d’une culture critique collective de l’IA. Dans l’ouvrage, je ne donne pas de solutions toutes faites. Je propose des agencements en expliquant que nous avons la capacité collective de se donner, à nous-mêmes, nos propres règles de délibération. Le livre ne propose pas une utopie anarchiste. Il pousse surtout à sortir de l’illusion, en reprenant en un sens le geste de Feuerbach dans l’Essence du christianisme. Il s’agit de reprendre à l’IA les qualités qu’elle a prises à l’humain. Les remettre à leur place, comme le propose Feuerbach : reprendre à dieu les qualités humaines dont le christianisme nous a dépossédées. Le geste du bouquin, c’est de trouver un moyen de sortir de l’aliénation et de redonner un sens à l’intelligence humaine, l’intelligence collective, la revaloriser face à cette entreprise de dévaluation à laquelle on assiste actuellement.

Propos recueillis par Jonathan Baudoin

Mathieu Corteel est philosophe et historien des sciences, chercheur associé à Harvard et chercheur postdoctal à Sciences Po. Il est l’auteur de Ni Dieu ni IA (La Découverte, 2025), Le Hasard et le Pathologique (Presses de Sciences Po, 2020)